Blir det læring av opplæring? Det vet vi strengt tatt som regel lite om. Noe særlig klokere blir vi heller ikke av å bruke de tradisjonelle spørreskjemaene. Skal vi få mer håndfast kunnskap må vi i dybden – og det koster tid og penger.

Hvorfor skal en bedrift bruke penger på å evaluere kompetansetiltak? Det kan være flere årsaker til dette:

- Legitimere investeringer i kompetanseutvikling gjennom dokumentasjon av effekter

- Gi et bedre grunnlag for beslutning om og utforming av tiltak i framtiden

- Gi tilbakemeldinger til de ulike aktørene/interessentene

- Dokumentere læring der det er nødvendig, for eksempel i forbindelse med sertifiseringer

Årsaken til at vi går i gang med en evaluering vil være styrende både for hvordan vi legger den opp, hvor store ressurser vi investerer i den, hvordan vi bruker resultatene og hvordan vi håndterer de organisasjonsinterne prosessene.

Men hvordan går vi så fram for å evaluere? Jeg skal presentere en velbrukt metodikk for dette, og også ta livet av en myte, nemlig den om at hvis deltakerne er fornøyde så har de lært noe.

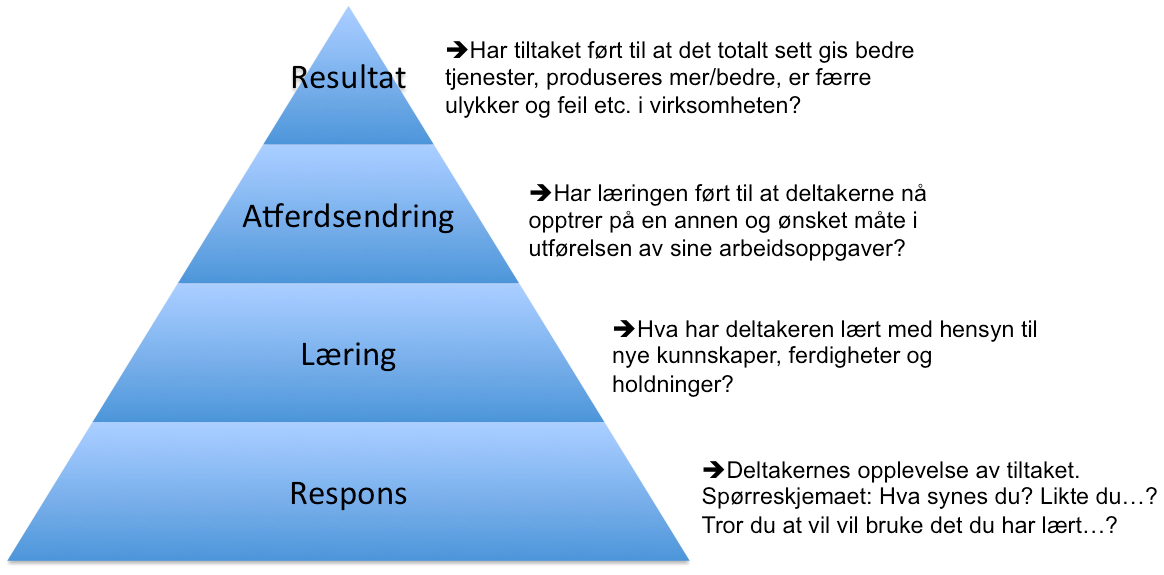

Kirkpatricks 4-nivåmodell

De fleste som jobber mer seriøst med evaluering av kompetansetiltak, bruker den såkalte Kirkpatricks 4-nivåmodell som basis. Boken som beskriver modellen kom første gang ut i 1957, ble revidert i 1975 og kom i en oppdatert versjon i 2006 (siste versjon, se her). Så man kan trygt si at den har vist sin slitestyrke.

Modellen viser hvordan man kan evaluere kompetansetiltak på fire nivåer, med ulik vanskelighetsgrad, men også utbytte:

Kirkpatrick selv var skeptisk til mulighetene for i det hele tatt å få noe særlig fornuftig ut av nivå 4 og mente at det var som å ”lete etter den hellige gral”. Likevel har mange forsøkt å få et metodisk grep på hvordan resultat-evaluering kan gjøres. Og det er ikke så rart, for i den grad toppledelsen er interessert i kompetansefeltet, er det særlig med kritiske spørsmål: Virker dette? Får vi noe igjen av investeringene?

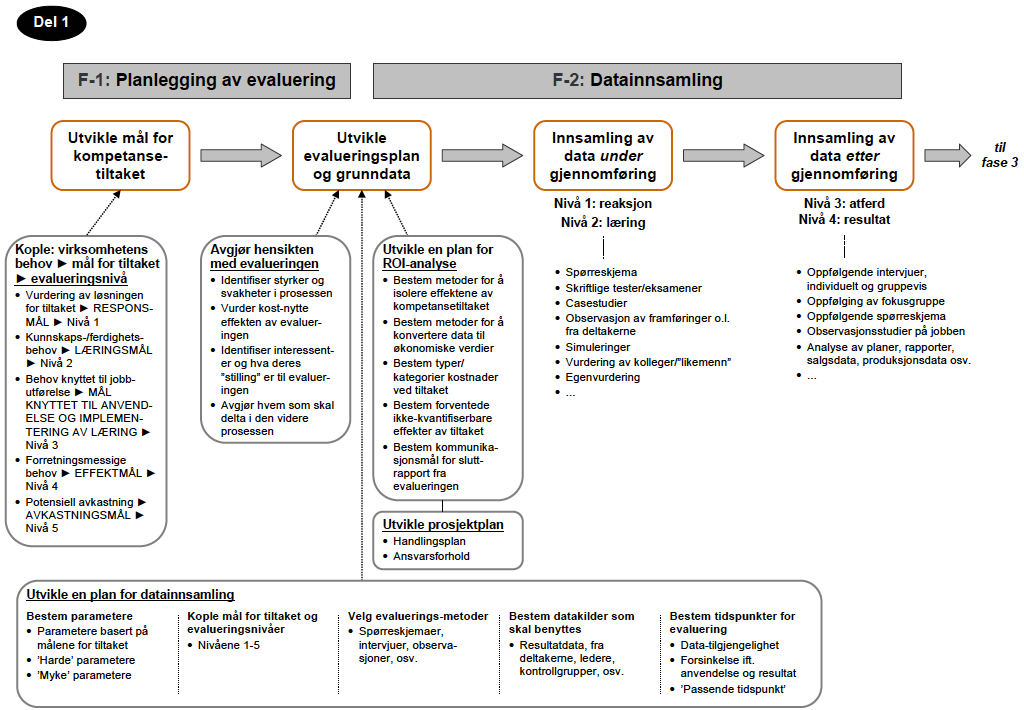

Den jeg synes har den beste og mest konkrete metodikken (Kirkpatrick beskrev egentlig bare en tilnærming, men var vag på praktisk gjennomføring) for dette, er Jack J. Phillips, særlig i boka ”How to Measure Training Results” (se hos Amazon). Hans store bidrag er at han har laget en bra og detaljert prosedyrebeskrivelse for hvordan man går fram trinn for trinn for å evaluere på ulike nivåer.

Jeg har skrevet et sammendrag på norsk av denne prosedyrebeskrivelsen, som kan lastes ned her: Phillips_flytskjema

Phillips’ innfører i tillegg et femte evalueringsnivå: avkastningsgrad/ROI, som er en ren matematisk utregning av utbytte i forhold til samlede investeringer i kompetansetiltaket.

Hvordan måler vi atferdsendringer?

Ofte vil det være så stor usikkerhet rundt de analysene man gjør på nivå 4 (eller 5), at man nøyer seg med å gå til nivå 3. Men la det være sagt: Det er svært sjeldent at noen norske bedrifter eller organisasjoner er interessert i å gjøre evalueringer på dette nivået. Men det skjer innimellom og en del av de som har gjort det, opplever at det også ga uvurderlig læring for de som selv jobber direkte med kompetanseutvikling.

Det er vanskelig å måle atferdsendringer! Det har å gjøre med at slike endringer gjerne skjer over tid. Vi har kanskje vært på en workshop, lært en ny prosedyre og tenkt at dette var smart. Så kommer vi tilbake på jobb, hvor vi fort faller tilbake til gamle vaner eller hvor det kanskje ikke er akseptert å endre en prosedyre sånn uten videre. Eller vi prøver litt, går tilbake til gammel metode, prøver litt mer, og så videre.

Atferdsendringer kan derfor som regel ikke måles før det har gått en tid, gjerne 2-4 måneder etter at opplæring ble gitt. Og da dukker det straks opp mange feilkilder. Kanskje var det ikke opplæringen i seg selv som ga støtet til en endring, men en konkret hendelse på jobben? Eller en ny kollega som kom som et friskt pust inn i avdelingen? Eller…? Så både det å måle atferdsendring og dernest å klare å isolere effekten av opplæringen som ble gitt, er krevende øvelser. Ofte bruker vi flere metoder i kombinasjon, for eksempel intervjuer med overordnede, sideordnede og underordnede, observasjonsstudier, statistikkanalyse osv. Og det er som regel hensiktsmessig å bruke kontrollgrupper når atferdsendringer skal måles.

Jeg har for øvrig hatt stor nytte av en bok av Judith Hale – Performance-based Evaluation – som gir helt konkrete teknikker for bl.a gjennomføring av observasjonsstudier (se boka hoa Amazon).

Misbruk av happy face-skjemaer

Hvor ofte har du ikke vært på et kurs eller seminar og blitt bedt om å fylle ut et evalueringsskjema på slutten. ”På en skala fra 1 til 5, hvordan vurderer du foreleser Per…?” Jeg sitter ofte og lurer på om disse skjemaene faktisk blir brukt til noe, det vil si til annet enn å gi arrangøren en bekreftelse på at det var ”bra nok” eller ”ikke bra nok”. Og om foreleser Per får en karakter på 3,7, mot et gjennomsnitt på 4,3 for alle foreleserne på seminaret, hva betyr det – at Per er dårligere enn gjennomsnittet?

Jeg tror nok ofte at vi bruker disse responsskjemaene fordi ”det gjør man da bare!”. Dataene blir ofte ikke brukt i det hele tatt eller de blir brukt til å trekke konklusjoner de overhodet ikke gir dekning for. Som vurderingen av foreleser Per. Et liten engelsk forskningsrapport (Tamkin m.fl.: Kirkpatrick and Beyond: A review of models of training evaluation – se her hos Amazon) ser nemlig blant annet på forskning som har vært gjort på sammenhengen mellom de ulike nivåene, med noen interessante funn:

- Det er som ofte en nær sammenheng mellom evaluering på nivå 1 og 2. Les: Hvis deltakerne selv er fornøyde og synes at de har lært noe, så har de sannsynligvis det.

- Men: Det finnes også mange studier som viser at deltakere som på et kurs har blitt provosert av foreleser, kanskje til og med sint, og derfor har gitt dårlig karakter på skjemaet, faktisk har lært mer enn de som bare var fornøyde og syntes at alle var ålreit. De provoserte har nemlig blitt utfordret og måtte ta stilling til det de ble presentert for på en helt annen måte.

- Det er liten/svak sammenheng mellom de to første nivåene på den ene siden og nivå 3 på den andre. Les: At deltakere har lært det de skulle, fører ikke nødvendigvis til endringer i utførelsen av arbeidsoppgaver.

Årsaken til det siste funnet er selvsagt å finne i barrierene for anvendelse av læring i organisasjoner. Det er identifisert opptil sytti slike barrierer, av både strukturell, kulturell og ledelsesmessig karakter.

Jeg synes særlig funnene rundt evaluering på nivå 1 er interessante. Det viser at vi nok legger for stor vekt på at deltakere skal være fornøyde og gi bra score til foreleser. Jeg kjenner i hvert fall på en grunnleggende tro på at mennesker må bli følelsesmessig engasjert om vi skal klare å sette i gang læringsprosesser i dem. Og det er ikke nødvendigvis slik at den friksjonsløse informasjonsoverføringen er det som er best egnet til dette. Hent fram provokatøren!